'Guerra' de páginas reacende debate sobre como Facebook escolhe o que sai do ar

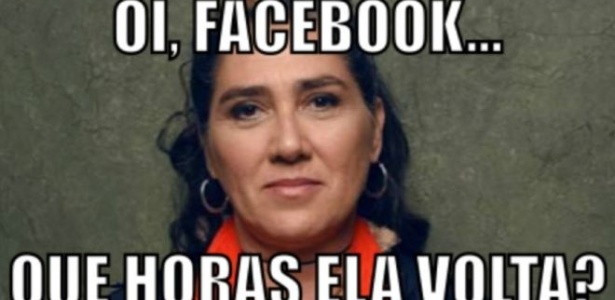

Uma semana após a controvérsia causada pela desativação da página da vlogueira Jout Jout no Facebook em uma suposta "guerra de páginas". O perfil da diretora de cinema Anna Muylaert, do filme Que Horas Ela Volta?, foi tirado do ar por denúncias de conteúdo impróprio.

A assessoria de Muylaert disse que. na última terça-feira, ela recebeu uma notificação a existência de imagens denunciadas por nudez e uma seleção dessas supostas imagens, para serem removidas. No entanto, a seleção proposta pela rede social mostra fotos da diretora com filhos e amigos, imagens do filme e até mesmo a foto de uma garrafa de refrigerante na geladeira.

"Achamos que foi essa 'guerra online' (entre conservadores e ativistas feministas e LGBT), porque Anna tem um perfil muito ativo, muito feminista, e defende causas sociais que são o calcanhar de Aquiles de muitas pessoas. Parece a única explicação lógica", disse a assessoria da diretora à BBC Brasil.

Desde que a página "Orgulho de ser hétero" - com 2 milhões de seguidores - saiu do ar, no dia 1º de novembro, haveria uma movimentação para fazer denúncias organizadas a páginas de ativistas feministas e LGBT. A página de Juliana Tolezano, a Jout Jout, teria sido uma delas, e voltou ao ar dias depois, seguido de um pedido de desculpas da empresa.

Na manhã desta quarta-feira, o perfil de Muylaert voltou ao ar. Procurado pela reportagem, o Facebook não respondeu se a desativação temporária estaria realmente ligada a uma ação coordenada para retirar páginas da rede.

Na semana passada, a BBC Brasil publicou trechos de uma conversa com a representante de políticas de produto do Facebook, a advogada Monica Bickert, a respeito do funcionamento e das polêmicas que cercam a retirada de conteúdo do ar.

Confira abaixo algumas das explicações de Bickert sobre como o Facebook decide o que ser removido da rede:

A necessidade de denunciar

"Qualquer conteúdo no Facebook pode ser denunciado. Isso inclui perfis, páginas, grupos, posts, comentários em posts, fotos, vídeos, qualquer coisa. O mais comum é ir para o canto superior direito do conteúdo, clicar em 'denunciar' e responder algumas perguntas, e isso chega à nossa equipe.

Quero enfatizar que dependemos muito de as pessoas denunciarem as coisas para nós. Isso nos ajuda a garantir que as coisas que estão sendo denunciadas realmente estão tendo um impacto negativo na comunidade. Não saímos por aí removendo conteúdo. As pessoas reclamam para nós e aí revisamos.

Temos sistemas de segurança para detectar determinadas coisas como spam e imagens de pornografia infantil, então nem tudo necessariamente precisa ser denunciado para ser visto. Mas discurso de ódio e assédio precisam ser denunciados. Não estamos ativamente buscando por isso."

Basta uma vez

"Quero derrubar o mito de que é preciso denunciar uma página muitas vezes para derrubá-la. Basta uma denúncia.

Se alguém denuncia algum tipo de conteúdo, isso vem para nós e ele é revisado. Se alguém denuncia de novo, ele é revisado de novo, mas segundo os mesmos padrões. Denunciar algo 200 vezes não muda a decisão que foi tomada.

Temos automação para fazer a triagem das denúncias para revisão. Às vezes mais de dez pessoas denunciam um tipo de conteúdo. Em vez de colocar 10 revisores para olhar aquele conteúdo logo, nós consolidamos as denúncias com um processo automático de triagem.

Mas, na maior parte das vezes, as denúncias estão sendo revisadas por pessoas reais: discurso de ódio, ameaça de violência, automutilação. Os revisores cometerão erros, mas são pessoas de verdade."

Quem avalia o conteúdo? E como?

"Há uma mistura de empregados do Facebook e terceiros contratados para fazer triagem de denúncias e revisões iniciais.

Nossa equipe de revisores é bastante internacional. Eles falam diversas dezenas de línguas, incluindo português brasileiro. Também temos essa equipe espalhada para garantir que o conteúdo seja revisado sete dias por semana, 24 horas por dia.

Não é um sistema perfeito, mas tentamos que, para cada conteúdo denunciado em cada língua, tenhamos alguém com a experiência apropriada para revisá-lo imediatamente.

A principal maneira pela qual garantimos que as decisões dos revisores sejam consistentes é dando a eles instruções concretas. Se temos a denúncia de uma ameaça de violência, damos instruções sobre como eles podem avaliar a credibilidade daquele discurso. Há algo na linguagem que nos faz acreditar que isso é algo que pode realmente levar a um ato de violência contra essa pessoa?

Porque claro, as pessoas usam palavras violentas o tempo todo, mas não queremos interferir com discurso que é de humor, satírico ou político, mas que não é uma ameaça séria.

Os revisores não têm liberdade para impor suas próprias opiniões na avaliação, precisam seguir as instruções que damos a eles. Semanalmente revisamos novamente parte do conteúdo que eles revisaram e vemos como as decisões foram tomadas.

Então se nós cometemos um erro, tentamos consertar este erro. E recebemos milhões de denúncias. Neste volume, erros acontecem todas as semanas. Parte do processo é fazer auditorias e mostrar aos revisores onde o erro foi cometido."

O 'ponto cego' das denúncias

"Se alguém denuncia uma página para nós, o revisor vai olhar se esta página, como um todo, viola nossos padrões.

Ele vai analisar coisas como o nome da página, a imagem no topo da página, a seção 'sobre' e parte do conteúdo da página. No entanto, algumas páginas têm 300 novas publicações por dia. O revisor analisará um número bem limitado desse conteúdo.

Se nessa página há uma publicação que viola nossos padrões e alguém denuncia a página, mas não esta publicação específica, pode ser que nosso revisor não a veja. Da mesma forma, se uma publicação é denunciada, o revisor pode avaliá-la e removê-la, mas pode não ver o contexto mais amplo da página, que também pode violar os padrões."

O dilema do contexto

"Para nossos revisores (o contexto) é um desafio, muitas vezes. Eles estão diante de um computador vendo uma imagem, mas não sabem quem são essas pessoas na vida real, não sabem o que está acontecendo, então têm que fazer um julgamento com base em contexto muito limitado.

Outra coisa que podem fazer é pedir que alguém da empresa dê uma olhada no conteúdo de vez em quando. Isso acontece. Eu mesma já fiz isso. Tentamos tomar a melhor decisão que podemos.

Quando os revisores veem uma imagem de nudez de uma pessoa real, por exemplo, eles sabem que não permitimos fotos de genitais e, em alguns casos, não permitimos fotos de mulheres de topless. Fotos de amamentação e do corpo pós-cirurgia são permitidas, mas topless em geral não é permitido.

Parte da razão para isso é que precisamos ter certeza que imagens como esta estão sendo compartilhadas com o consentimento de quem aparece nelas, garantir que não é 'pornografia de vingança'. Erramos para o lado da segurança. Os revisores não conseguem, necessariamente, saber o contexto em que as fotos estão.

Há momentos em diferentes países em que as discussões podem ficar agressivas e começamos a ver mais coisas como discurso de ódio e bullying de indivíduos. Se sabemos de algo que pode ser um problema em algum país, tentamos garantir que nossos revisores estejam cientes disso. Isso não muda os padrões que aplicamos, mas é útil ter esta informação.

Mantemos os revisores informados sobre algumas das palavras que estão sendo usadas em discursos de ódio no Brasil, por exemplo, e sobre quais são algumas das tendências de como as pessoas podem atacar grupos ou indivíduos. Quando o idioma é um problema, direcionamos o conteúdo para funcionários que falam a língua."

Discurso de ódio x liberdade de expressão

"Estamos constantemente buscando novas formas de refinar nossas políticas e ver se há maneiras de permitir mais liberdade de expressão enquanto garantimos que as pessoas estão seguras, mas isso é um dos desafios que enfrentamos.

Um exemplo é o discurso de ódio. Não há uma única definição disso no mundo, então não podemos simplesmente dizer a nossos revisores: 'se for discurso de ódio, removam'. Decidimos focar nossa definição de discurso de ódio no ataque a uma pessoa ou grupo de pessoas.

A orientação que damos a eles é: se for um ataque direito a pessoas, baseado em característica como raça, religião, nacionalidade, identidade de gênero, nós removeremos. Mas se é uma crítica a um país ou instituição, por exemplo, deixamos essa crítica como parte do debate público.

Se há um ataque a uma pessoa ou grupo de pessoas por causa de sua orientação sexual, por exemplo, não importa quem diz, nem se é um político. Se alguém ataca diretamente pessoas por ser gay, diz que são 'pessoas ruins' ou coisas do tipo isso viola nossas políticas e pode ser removido.

Mas se alguém critica um político por seus posicionamentos sobre um assunto no Congresso, ou estão criticando uma instituição, como um grupo LGBT, permitimos esse tipo de discurso.

Garantir que as pessoas saibam que estão seguras e não sofrerão ataques no Facebook é uma parte importante de dar voz a quem poderia se sentir silenciado e impedido de participar de uma discussão."

Assédio

"Temos uma política contra assédio online que inclui, entre outros comportamentos, tentativas repetidas de deixar alguém desconfortável ou de assediar alguém.

Analisamos coisas como: quem está por trás da conta? Se é alguém que tem um registro de múltiplas instâncias de discurso de ódio, em determinado momento haverá consequências sérias. Pelo menos serão proibidos de postar por algum tempo.

Também olhamos para coisas como a autenticidade das contas, se elas são verdadeiras, se foram criadas diversas contas falsas para coordenar algum mau comportamento. Às vezes conseguimos detectar isso. Por isso exigimos que as pessoas usem suas identidades verdadeiras no site. Dá trabalho pôr isso em prática, mas estamos tentando acertar.

Se alguém é denunciado constantemente, isso fica registrado e é considerado contexto relevante para a análise de um conteúdo postado por essa pessoa.

Quando se trata de violência sexual, temos padrões muito rigorosos. Mesmo 'piadas' sobre estupro podem ser removidas de acordo com nossos padrões. Algumas pessoas podem achar isso engraçado, mas não aceitamos isso."

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.